Ethiklabel für KI-Systeme entwickelt

Das Arbeitspapier „AI Ethics: From Principles to Practice – An interdisciplinary framework to operationalise AI ethics“ zeigt, wie allgemeine KI-Ethikprinzipien europaweit in die Praxis überführt werden können. Die Autorinnen und Autoren sind Teil der von der Bertelsmann Stiftung und des VDE ins Leben gerufenen „AI Ethics Impact Group“. Aus dem ITAS sind drei Forschende beteiligt: Rafaela Hillerbrand, Torsten Fleischer und Paul Grünke.

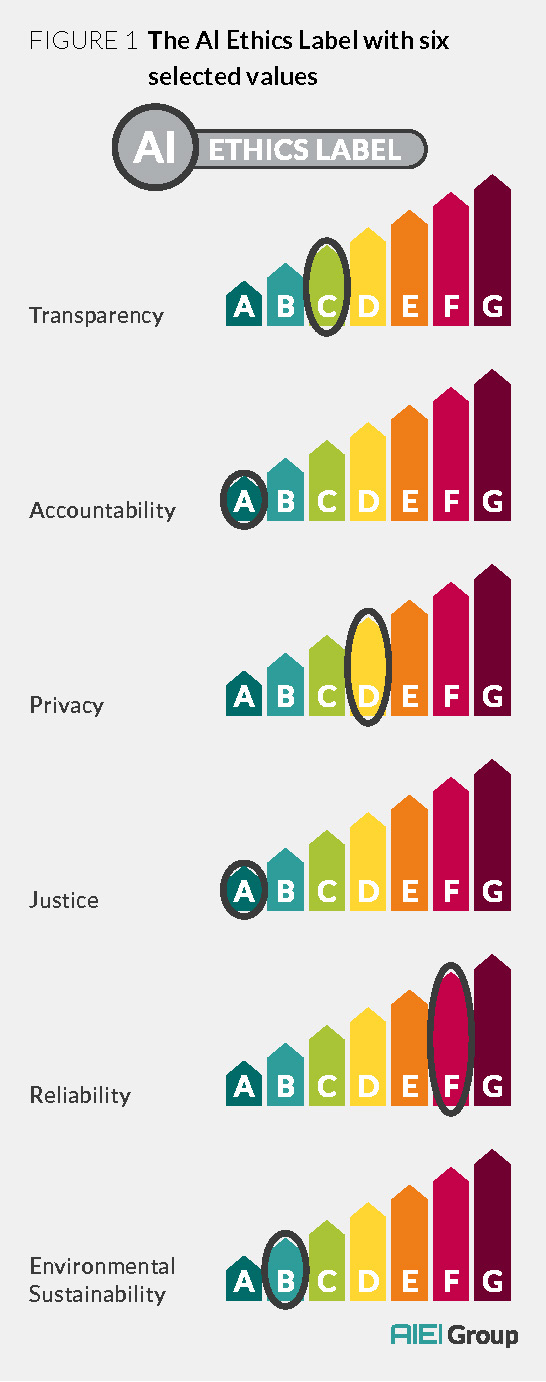

Im Mittelpunkt des Papiers steht der Entwurf eines Ethik-Labels für KI-Systeme, optisch angelehnt an Energieeffizienzlabel für Kühlschränke und andere elektronische Geräte. Mithilfe des Labels können Produzenten von KI-Systemen die Qualität ihrer Produkte einstufen. Diese werden dadurch auf dem Markt vergleichbar und die ethischen Anforderungen transparent gemacht. Das Label setzt sich aus den Werten Transparenz, Verantwortlichkeit, Schutz der Privatsphäre, Gerechtigkeit, Verlässlichkeit und Nachhaltigkeit zusammen.

Welche Anforderungen für die unterschiedlichen Stufen erfüllt werden müssen, kann mithilfe des sogenannten „WKIO-Modells“ bestimmt werden, bei dem Werte, Kriterien, Indikatoren und Observablen zusammenwirken.

Risiko-Matrix für unterschiedliche Einsatzzwecke

Die Forscherinnen und Forscher weisen in ihrer Veröffentlichung darauf hin, dass es relevant ist, in welchem Kontext die algorithmischen Systeme genutzt werden. So sei beispielsweise bei einem in der Landwirtschaft eingesetzten System ein geringerer Grad von Transparenz erforderlich als bei der Verarbeitung personenbezogener Daten. Um zu überprüfen, ob ein KI-Einsatz für einen bestimmten Zweck ethisch akzeptabel ist, haben die Forschenden eine so genannte Risiko-Matrix entwickelt.

Die Verfasser betrachten die vorgestellten Lösungsansätze als Werkzeuge, die politischen Akteuren und Kontrollbehörden helfen, Anforderungen an KI-Systeme zu konkretisieren und wirksam zu kontrollieren. Auch Firmen und Organisationen, die algorithmische Systeme einsetzen möchten, könnten das Modell nutzen. Die Werkzeuge müssen nun in der Praxis erprobt und dann weiter ausgearbeitet werden, so die Autorinnen und Autoren. (09.04.2020)

Weiterführende Links oder Dokumente:

- Arbeitspapier AI Ethics: From Principles to Practice im Volltext (PDF)

- Ausführlicher Text und Video zum Arbeitspapier auf der Projektseite