technik.kontrovers 2019

-

type of event:

Themenabende

- place:ITAS, Karlstraße 11, 76133 Karlsruhe

-

date:

2019

- links:

Mensch | Macht | Klima. Klimaschonender Alltag – geht das?

Was können wir als Individuen tun, um die drohende Klimakrise aufzuhalten? Ein Thema, das derzeit von der lokalen bis hin zur internationalen Ebene breit und intensiv diskutiert wird. Auch das ITAS hat sich dieser Frage angenommen und in der Reihe technik.kontrovers am 17. September 2019 die Diskussion mit Bürgerinnen und Bürgern gesucht.

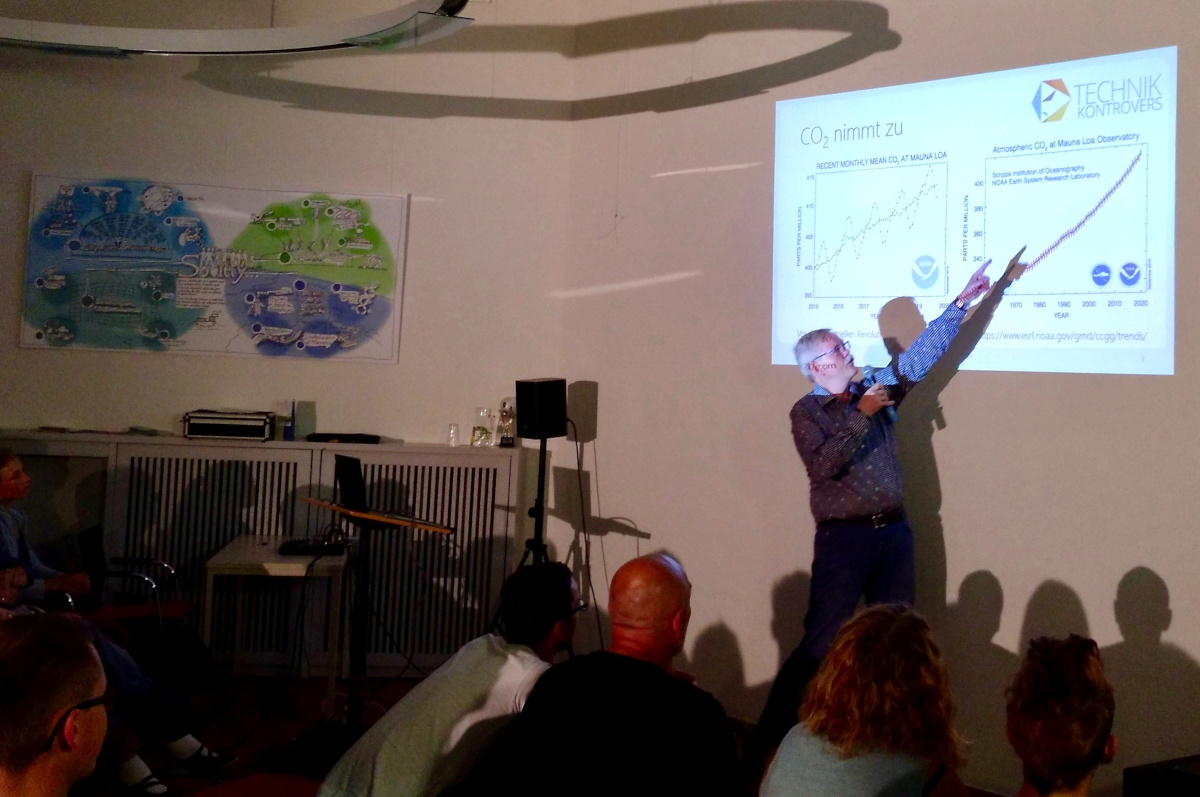

Eingeführt in die Thematik hat Peter Braesicke, Professor am Institut für Meteorologie und Klimaforschung am KIT, indem er die Dimensionen des Klimawandels erläuterte und auf die Geschichte seiner Erforschung einging: Der Anteil an Kohlenstoffdioxid in der Luft nimmt seit der industriellen Revolution kontinuierlich zu. Dass dieses Molekül einen enormen Einfluss auf die Temperatur und das Klima der Erde nimmt, ist bereits seit 1896 bekannt. Doch nicht bloß das CO2 hat einen Einfluss auf das Klima, vielmehr auch andere Verbindungen, wie FCKWs (Flurchlorkohlenwasserstoffen), die auch zur günstigen Herstellung von Bauschaum verwendet wurden. FCKWs sind maßgeblich an der Zerstörung der Ozonschicht (unserem UV Schutz) beteiligt und sind aufgrund ihrer klimaschädlichen Wirkung durch das Montrealer Protokolle und seine Nachträge und Erweiterungen verboten worden. Langsam zeigt sich daher eine Erholung der Ozonschicht, ein Teilerfolg, jedoch nicht die Lösung des Klimaproblems.

Die zweite Referentin des Abends, Eva Wendeberg, Geoökologin und wissenschaftliche Mitarbeiterin am ITAS, gab Einblicke in die Lebenszyklusanalyse. Die Methode erlaubt es, Umweltauswirkungen einzelner Produkte zu bilanzieren. Am Beispiel des Autos wurden die verschiedenen Schritte der Wertschöpfungskette beleuchtet, beginnend mit der Rohstoffgewinnung, über die Produktion, den Handel, die Nutzung und die abschließende Entsorgung. Dabei werden bei jedem Schritt CO2-Emissionen frei, die sich auf das Klimasystem auswirken. Anschließend begab sich das Publikum mit ihrer Hilfe auf eine Reise durch den Alltag, um zu erfahren, welche Alltagsaktivitäten mit welchen Treibhausgasemissionen verbunden sind.

Durch die dritte Referentin des Abends, Sarah Meyer-Soylu, ebenfalls Geoökologin am ITAS, erfuhren die Gäste zudem mehr über das Projekt „Klimaschutz gemeinsam wagen!“ – ein Vorhaben, das gemeinsam mit Menschen in Karlsruhe Selbstexperimente für einen klimaschonenden Alltag entwirft und umsetzt, sowie Klimacoaches als Multiplikatoren für zivilgesellschaftliches Engagement im Bereich Klimaschutz ausbildet.

Nach den Vorträgen fand eine interessante Diskussion zwischen Publikum und Referenten statt. Dabei kamen Fragen auf, etwa inwiefern die Politik noch stärker handeln müsse und ob das Ziel, die globale Erwärmung auf 1,5 Grad zu begrenzen, überhaupt noch realistisch und erreichbar sei.

Das technik.kontrovers-Team dankt allen Gästen für die lebhafte Beteiligung an diesem Abend!

Wie fair ist die digitale Welt? Diskriminierung durch Algorithmen

„Wie fair ist die digitale Welt? – Diskriminierungsrisiken durch Algorithmen“. Ein Titel mit vielen Unbekannten: Was ist Fairness? Was ist eigentlich eine „digitale Welt“? Was genau versteht man unter Diskriminierung und was ist überhaupt ein Algorithmus? Mit diesen Fragestellungen beschäftigte sich der technik.kontrovers Themenabend am 26. Februar 2019.

Eingeführt in die Thematik hat diesmal Reinhard Heil, der am ITAS im Bereich der Innovationsprozesse und Technikfolgen forscht. Digitale Informations- und Kommunikationstechnologien durchdringen nahezu alle Lebensbereiche, wie beispielsweise das bargeldlose Zahlen, das Recherchieren im Internet, das Tracken einer sportlichen Aktivität und vieles mehr. All diese Aktionen erzeugen umfangreiche Datenmengen, die kaum mehr zu überblicken sind, Stichwort „Big Data“. Komplexe Algorithmen erlauben es, große Datenmengen in vergleichsweise sehr kurzer Zeit verarbeiten und analysieren zu können.

Solche Algorithmen können, so die Hoffnung, menschliche Fehler, Fehl- und Vorurteile bei der Verarbeitung von Informationen vermindern und nach den programmierten Kriterien stets objektiv und einheitlich vorgehend entscheiden.

Der zweite Referent des Abends, Carsten Orwat wies auf mögliche Risiken hin, die mit dem Einsatz von Algorithmen verbunden sind. Durch die Verwendung verzerrter Datensätze, Über- und Unterrepräsentation bestimmter Merkmale und zu spezialisierte Modelle kann es zu Diskriminierungen geschützter Gruppierungen und dem Auftreten neuer Diskriminierungstypen kommen. Prominente Beispiele einer diskriminierenden Software sind beispielsweise Kreditvergabe- und Personaleinstellungssoftware, bei der geschützte Personengruppen benachteiligt wurden.

Im Anschluss wurden Möglichkeiten erörtert, wie man Diskriminierung durch Algorithmen verhindern könnte. Genannt wurden hierbei die Entwicklung und der Einsatz diskriminierungsvermeidender Systeme, Antidiskriminierungsauflagen, zum Beispiel das Allgemeine Gleichbehandlungsgesetz (AGG), und -Einrichtungen, wie der Antidiskriminierungsstelle des Bundes (ADS), sowie der gesellschaftliche Diskurs über das Thema.

Nach den Vorträgen fand eine interessante Diskussion zwischen Publikum und Referenten statt. Dabei kamen Fragen auf, ob nicht auch Menschen diskriminieren und was genau der Unterschied zu Algorithmen sei und wer im Diskriminierungsfall hafte: der einzelne Programmierer oder das Unternehmen?

Fazit einer Besucherin: Ob unmittelbare Diskriminierung durch Menschen oder vermittelt durch Algorithmen – wichtig ist, sich für eine offene, diskriminierungsfreie Gesellschaft einzusetzen.

Das technik.kontrovers-Team dankt allen Gästen für die lebhafte Beteiligung an diesem Abend!

technik.kontrovers

In der Reihe „technik.kontrovers“ präsentiert das ITAS gesellschaftlich brisante Technikthemen, zu denen am Institut geforscht wird. Die vierteljährlich stattfindenden Veranstaltungen haben das Ziel, vernetzend, interaktiv und vielfältig vorzugehen. Die Forscherinnen und Forscher skizzieren mit kurzen Impulsen unterschiedliche Positionen zur gesellschaftlichen Dimension bestimmter Technikbereiche und suchen damit den unmittelbaren – und gerne auch kontroversen – Austausch mit der Öffentlichkeit.

Veranstaltungen aus den Jahren 2014/2015 - 2016 - 2017 - 2018 - 2019 - 2020 - 2021 - 2022 - 2023 - 2024